汕头网站制作-Robots文件写法+3个实战经验分享 小白看过来

最近看到高端SEO社群里有同学评论Robots相关问题,咱们从实战的视点,给咱们讲讲怎样写Robots写法,以及在实战中或许遇到的问题,都给咱们讲一下!期望能够协助更多不明白的同学!

Robots界说

什么是Robots,简略来讲,其实Robots便是放在网站根目录下的一个TXT文件,可是这个TXT文件对搜索引擎规矩,哪些页面能够拜访,哪些页面不可。

Robots一般放在网站根目录下,文件名固定为robots.txt的(悉数小写)、当搜索引擎要爬取咱们网站的时分,会先读一下robots.txt里边的内容,判别哪些URL能够拜访,哪些不可,然后进行爬取、录入。

Robots规矩

常用的几类语法:

User-agent: 界说搜索引擎的类型

google蜘蛛:googlebot

百度蜘蛛:baiduspider

yahoo蜘蛛:slurp

alexa蜘蛛:ia_archiver

msn蜘蛛:msnbot

Disallow: 界说制止搜索引擎录入的地址

举个比如来讲:User-agent: * Disallow: /

制止一切搜索引擎拜访网站,(*)为通配符

Allow: 界说答应搜索引擎录入的地址

User-agent: * Disallow: /a/ Allow: /a/b

如上面比如,约束搜索引擎抓取a目录,但答应搜索引擎抓取a目录下的b目录

$通配符

User-agent: * Allow: .htm$

匹配URL结束的字符。如下面代码将答应蜘蛛拜访以.htm为后缀的URL:

*通配符

User-agent: * Disallow: /*.htm

告知蜘蛛匹配恣意一段字符。如下面一段代码将制止一切蜘蛛抓取一切htm文件:

Sitemaps方位

Sitemap: http://www.xxx.com/sitemap.xml

Robots心得

1、许多朋友都喜爱让搜索引擎不抓取自己的后台,所以将自己的后台地址写到robots.txt里边,其实个人不主张这样做,由于考虑到网络安全,许多Hack都喜爱经过robots.txt看咱们的后台,便利进犯!

2、网站有必要要有robots.txt,假如汕头网站制作网站没有robots.txt,搜索引擎随意抓取的话,或许会抓取到一些低质量页面,然后导致网站录入、流量受到影响,如上图是没有robots.txt。

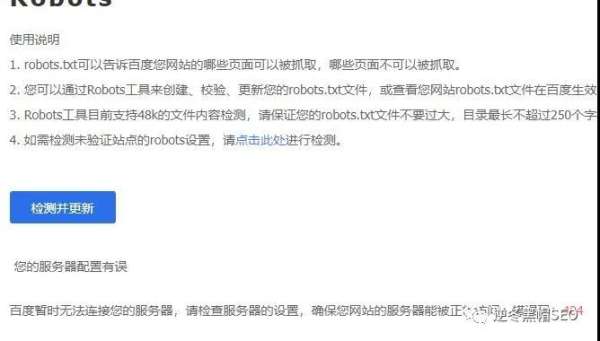

3、当咱们做完robots.txt后,必定要去【百度站长东西渠道】抓取、测验robots.txt,以及测验URL是否能够抓取。